什么是 The Language of Motion?

The Language of Motion 是斯坦福大学开发的一个统一多模态语言模型项目。它旨在让计算机能够像人类一样,理解和处理语言(包括语音和文字)以及非语言信息(如手势、表情和身体动作)之间的复杂交互。这个模型的厉害之处在于,它不仅能理解这些信息,还能在不同的模态之间进行转换,例如将语音转换为动作,将文本转换为动作,或者将动作转换为情感等。这就像我们人类一样,听到一句话,脑海里会浮现对应的动作画面,或者看到一个动作,能理解其中的情感含义。

The Language of Motion 如何工作?

多模态信息的融合与处理

这个模型的关键在于它能够同时处理语音、文字和动作。它不是将这些信息分开处理,而是将它们整合在一起,形成一个统一的理解。这就像我们看电影一样,我们同时接收到人物的对话、表情和动作,然后综合理解整个场景的含义。The Language of Motion 也是如此,它能同时理解这些信息,并建立它们之间的联系。

模态间的转换能力

The Language of Motion 的一大亮点是它强大的模态转换能力。具体来说,它可以实现:

- 语音到动作:例如,你对着电脑说“跳起来”,虚拟人物就能做出跳跃的动作。

- 文本到动作:你输入一段文字描述“他开心地挥舞着手臂”,虚拟人物就能做出对应的动作。

- 动作到情感:虚拟人物做出一个悲伤的动作,模型就能理解并识别出这是悲伤的情绪。

这种模态转换能力使得虚拟人物的交互更加自然和智能。

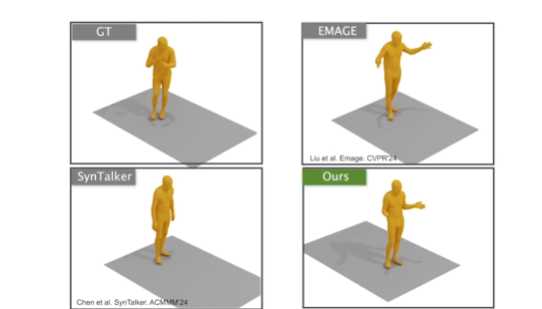

动作的自然性和多样性

The Language of Motion 生成的动作具有较好的同步性,也就是说,动作和语音能够协调一致,不会出现“嘴巴动了,声音没出来”或者“动作和语音不匹配”的情况。更重要的是,它生成的动作是自然且多样化的,不像一些简单的动画那样显得僵硬和重复。这使得虚拟人物的动作更加生动,更具表现力。

The Language of Motion 的应用场景

The Language of Motion 的应用前景非常广阔,它可以用于:

- 创建自然交流的虚拟角色:在游戏、虚拟现实、在线教育等领域,我们可以利用 The Language of Motion 创建更加智能和自然的虚拟人物,让用户与虚拟人物的交互更加真实和沉浸。例如,在游戏中,NPC 可以根据玩家的语音指令做出相应的动作,或者根据玩家的情绪变化做出不同的反应。

- 人机交互:我们可以通过语音或文字控制机器人做出各种动作,或者让机器人通过动作表达情感。

- 动画制作:可以利用该模型快速生成动画人物的动作,提高动画制作的效率。

- 情感分析:通过分析人的动作,可以更好地理解人的情感状态。

- 康复训练:可以通过动作捕捉和分析,帮助患者进行康复训练。

如何使用 The Language of Motion?

目前 The Language of Motion 项目还在研究阶段,并没有公开提供直接使用的 API 或软件。但是,你可以访问项目的官方网站 https://languageofmotion.github.io ,了解更多关于该项目的详细信息,包括论文、演示视频和代码等。

如果你想深入研究,可以尝试以下步骤:

- 阅读项目论文:仔细阅读项目论文,了解其背后的原理和技术细节。

- 查看演示视频:通过观看演示视频,直观了解该模型的功能和效果。

- 关注项目代码:如果项目公开了代码,可以尝试运行代码,了解其实现方式。

- 参与社区讨论:加入相关社区,与其他研究者交流,共同探讨该项目的未来发展。

总结

The Language of Motion 是一个非常有潜力的多模态语言模型项目,它能够将语音、文字和动作等多种信息融合在一起,并实现它们之间的转换。这使得计算机能够更好地理解人类的语言和行为,为创建更加智能和自然的虚拟角色提供了新的可能性。虽然目前该项目还在研究阶段,但其未来的应用前景非常广阔,值得我们持续关注。

我认为:这The Language of Motion的出现,仿佛是给AI插上了一双翅膀,让它们不再是冷冰冰的代码,而是开始有了“人性”。这不单单是技术上的突破,更是对人机交互方式的一种全新探索。看着它能理解人类的语言、动作,并做出相应的反应,就像看着一个蹒跚学步的孩子,慢慢地学会了表达,这背后蕴藏的,是对未来无限的憧憬,以及对人与机器和谐共处的渴望。然而,我们也要警惕,这强大的力量如果被滥用,可能会带来意想不到的后果。所以,在追求技术进步的同时,更要坚守道德的底线,让科技真正服务于人类,而不是反噬人类。

© 版权声明

文章版权归作者所有,未经允许请勿转载。