GPT学术优化

论文阅读、润色和写作,一键Python与C++项目解析项目

Dolphin-2.9.1-Mixtral-1x22b是由Cognitive Computations开发的高性能文本生成与对话模型,适用于多种应用场景,但需用户自行负责内容合规性。

本文详细介绍了由Cognitive Computations团队开发的Dolphin-2.9.1-Mixtral-1x22b模型,包括其开发背景、技术特点、训练过程、应用场景及使用限制。该模型基于Apache-2.0许可证,适用于多种文本生成和对话任务,具有高度的灵活性和适应性。

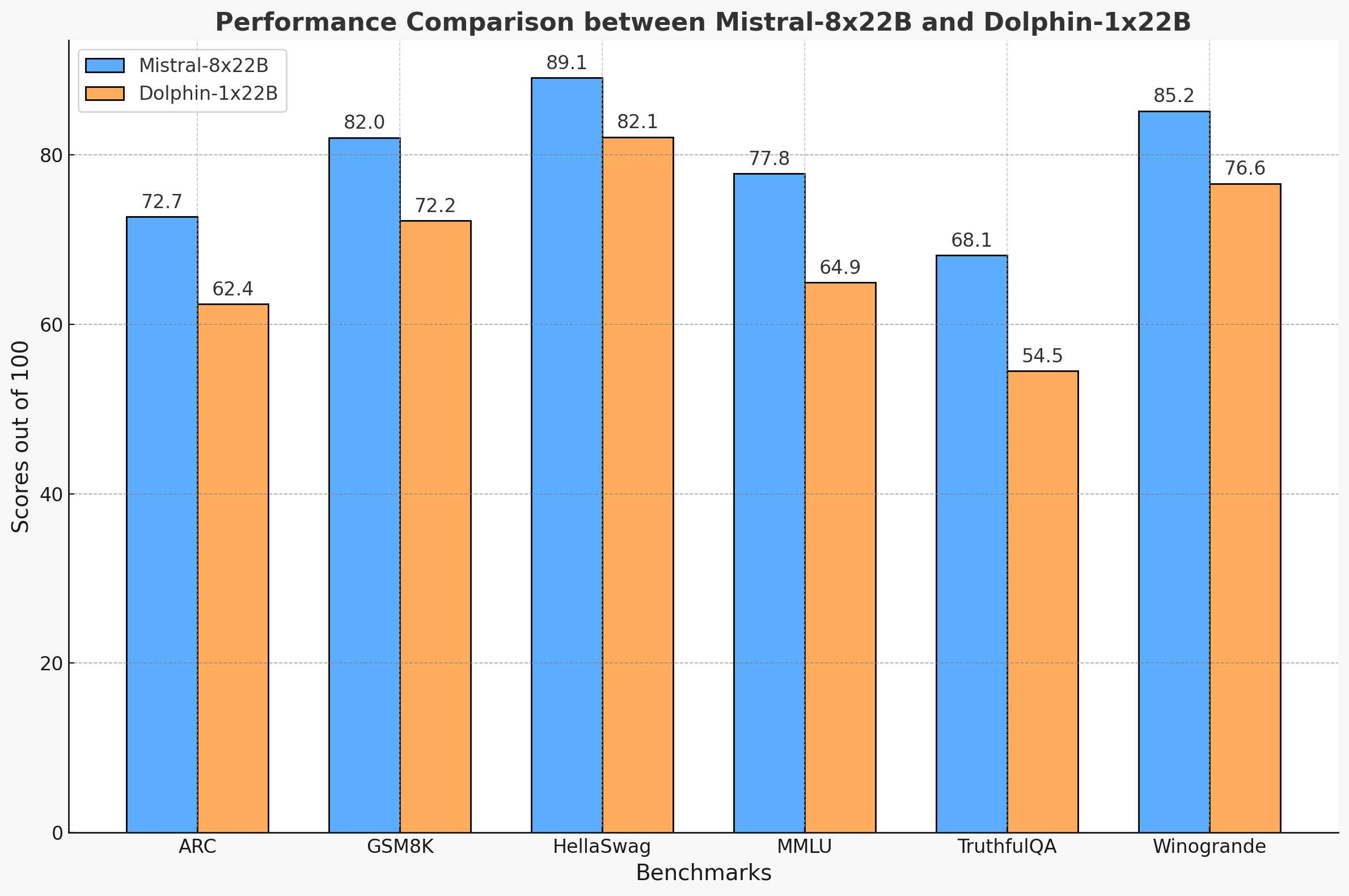

Dolphin-2.9.1-Mixtral-1x22b模型是由Eric Hartford、Lucas Atkins和Fernando Fernandes领导的团队在Crusoe Cloud提供的8xH100平台上,经过27小时训练完成的。该模型基于Dolphin-2.9-Mixtral-8x22b,通过精细调整和优化,提取出一个单一的专家模型,以保持原始模型的性能。

模型训练使用了以下参数:

训练过程中,模型的损失稳步下降,显示出良好的训练效果。

Dolphin-2.9.1-Mixtral-1x22b模型适用于多种场景,包括但不限于:

Dolphin-2.9.1-Mixtral-1x22b模型是一个功能强大的文本处理工具,适用于多种复杂的文本生成和对话任务。尽管模型提供了强大的功能,但用户需注意内容的合规性和道德责任。通过合理的应用,该模型能够在多个领域发挥重要作用。