引言

尽管o1系列模型在复杂推理和学术竞赛领域表现出色,但实际体验中也发现了一些局限性。本文将详细探讨o1模型在简单数学问题、复杂代码和文字处理方面的表现,并总结其适用场景。

o1模型在简单数学问题上的表现

不擅长简单的牛角尖数学问题

在实际体验中,o1模型对一些简单但容易出错的数学问题表现不佳。例如:

- 比较大小问题:问“9.11和9.9谁大”这种简单的比较问题,o1模型有时会给出错误的答案。

- 日常生活问题:比如“放多少天假”这种涉及简单计算的问题,o1模型的回答并不总是准确。

原因分析

这些简单问题往往不需要复杂的推理能力,更多依赖于基础计算和常识,这可能是o1模型的一个弱项。

o1模型在复杂代码和文字处理上的表现

复杂代码生成

尽管o1模型在编程任务中有一定表现,但在处理复杂代码时仍有不足。例如,生成复杂的Bash脚本或Python代码时,o1模型可能会出现逻辑错误或未能完全理解任务需求。

文字处理

在文字写作和复杂的文字处理任务中,o1模型的表现也不尽如人意。例如,对于李继刚的Prompt,o1模型的生成内容可能不够连贯或存在语法错误。

原因分析

这些任务通常需要更高的上下文理解和逻辑组织能力,o1模型在这方面的表现还需进一步优化。

o1模型的适用场景

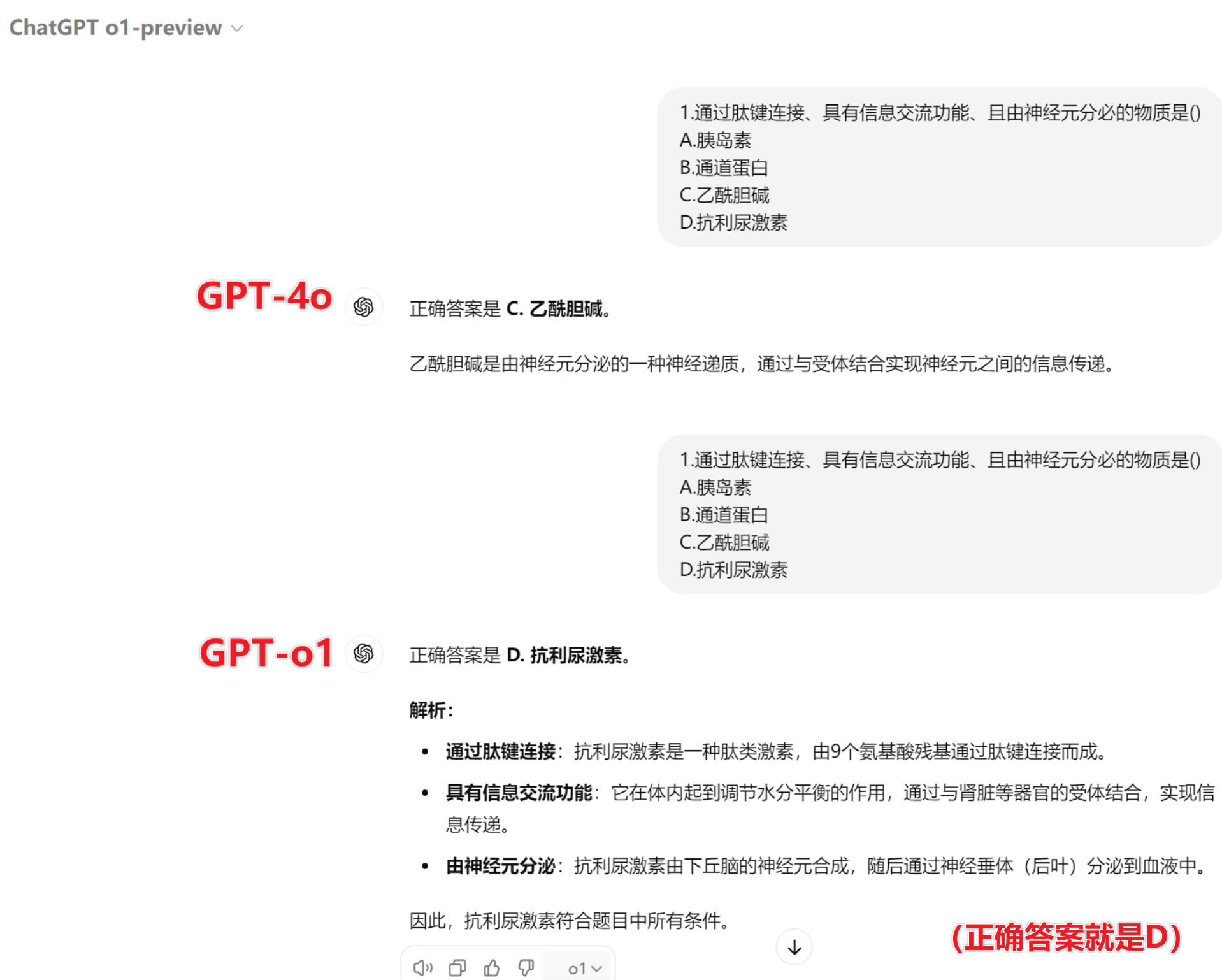

高难度学术竞赛知识问题

o1模型在处理高难度的学术竞赛问题上表现出色,比如博士物理问题和IOI信息学奥赛题目。其复杂推理能力和多领域知识储备使其在这些场景中具有明显优势。

实际应用体验

在实际应用中,我们发现:

- 4o模型:在很多情况下给出的答案都是错误的。

- o1模型:在高难度问题上的正确率显著高于4o模型,基本都能给出正确答案。

结论与感悟

我认为:尽管o1模型在一些简单问题和复杂代码、文字处理上存在局限性,但其在高难度学术竞赛知识问题上的表现无疑是令人瞩目的。这提醒我们,人工智能模型在特定领域和任务中的表现仍需不断优化,同时也需要我们在使用过程中根据具体需求选择合适的模型。未来,随着技术的不断进步,我们有理由期待人工智能在更多领域中展现出更强大的能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。