AVCLabs

AI自动移除视频背景

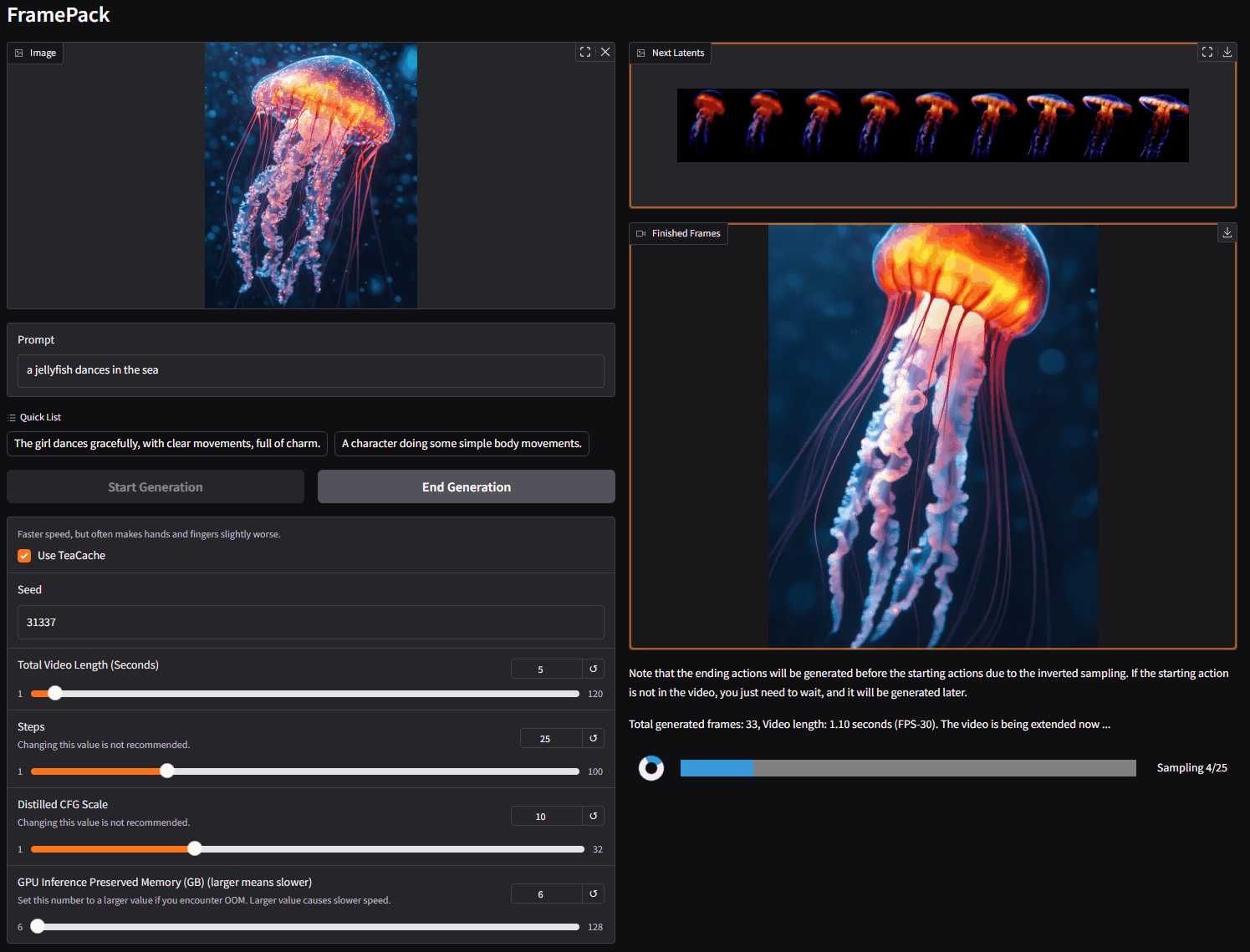

FramePack 是一种下一帧(下一帧部分)预测的神经网络结构,用于逐步生成视频。它通过将输入上下文压缩到固定长度,使得生成工作量与视频长度无关。这意味着即使在笔记本电脑 GPU 上,使用 13B 模型也能处理大量的帧。

简单来说,你可以把它想象成一个视频版的图像扩散模型,让你能够更高效地生成视频。

update.bat 文件进行更新,务必执行此步骤,以确保使用最新版本并修复潜在的 bug。run.bat 文件启动 FramePack。注意:模型将自动从 HuggingFace 下载,预计需要下载超过 30GB 的数据。

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126pip install -r requirements.txtpython demo_gradio.py 可以通过 --share、--port、--server 等参数进行配置。

例如,要在 Linux 上安装 sage-attention:

pip install sageattention==1.0.6注意: 建议先尝试不安装 sage-attention,因为它可能会对结果产生影响,尽管影响很小。

请注意,唯一的 FramePack 官方网站是此 GitHub 仓库。 任何其他网站,包括但不限于 framepack.co、frame_pack.co 等,都是垃圾网站和虚假网站。 请勿在这些网站上花钱或下载文件,谨防上当受骗!

总结:

FramePack 是一款基于下一帧预测的视频生成工具,其优势在于高效、资源需求低,并提供实时反馈。它适用于对视频生成感兴趣,但受限于硬件资源的用户。通过简单的安装步骤,用户即可在自己的设备上体验视频生成的乐趣。需要注意的是,用户应从官方渠道获取软件,谨防网络诈骗。

目标用户: 对视频生成感兴趣,但受限于硬件资源,希望在本地电脑上进行创作的用户,例如学生、独立开发者、小型工作室等。

使用场景: 视频内容创作、AI艺术创作、实验性视频生成等。