OpenAI推出更强推理模型o1–pro:百万Token收费高达600美元,为何如此昂贵?

什么是OpenAI o1-pro模型?它有哪些特性?

OpenAI在其开发者API中推出了o1-pro,这是一个比o1更强大的推理模型。o1-pro通过使用更多的计算资源来提供更优质的响应。它具备以下特性:

- 更好的响应: 投入更多计算资源,优化响应质量。

- 仅对特定开发者开放: 目前仅对Tier 1–5开发者开放。

- 功能丰富: 支持视觉、函数调用、结构化输出。

- 兼容性强: 与响应和Batch API兼容。

o1-pro模型的价格是多少?与其他模型相比如何?

o1-pro的定价非常高昂,堪称OpenAI有史以来最贵的模型:

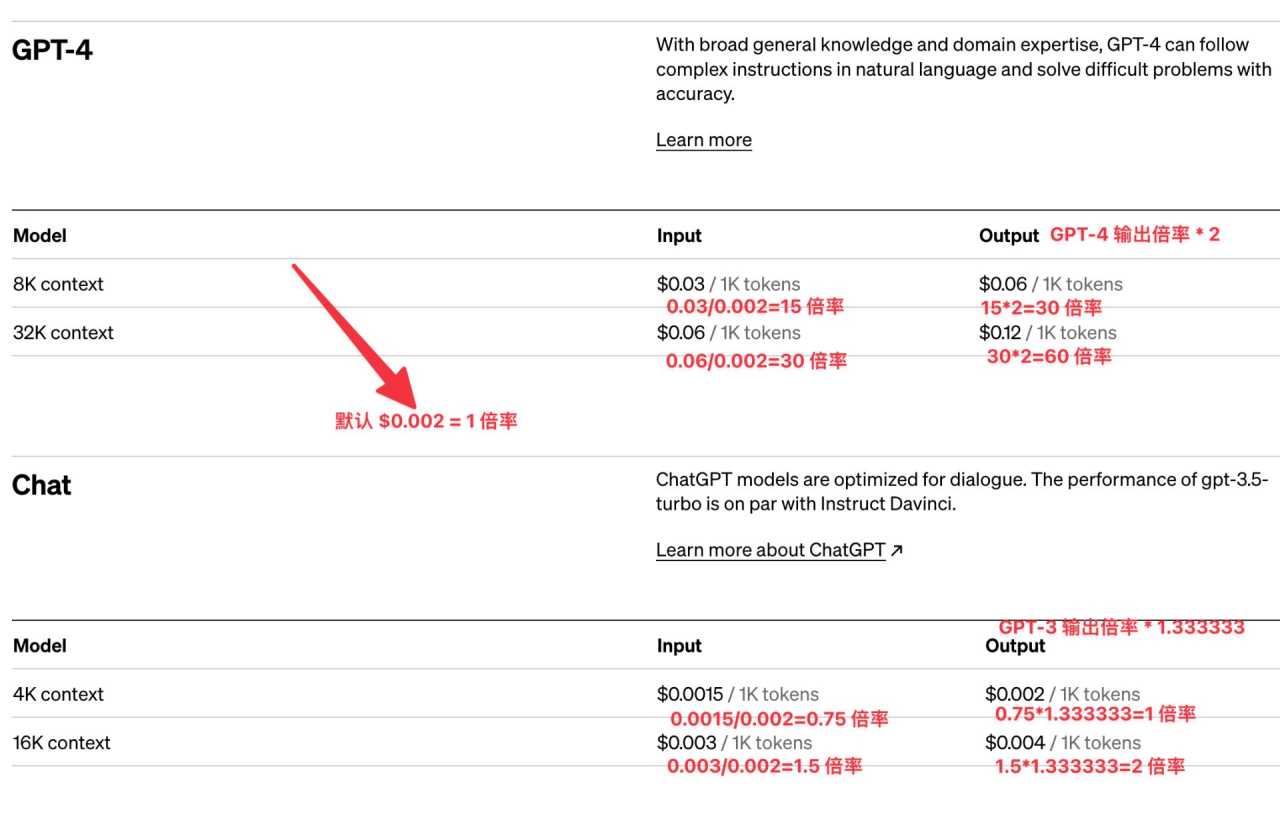

- 输入Token: 每100万输入token(约75万个单词)收费150美元。

- 输出Token: 每100万输出token收费600美元。

有网友调侃,简单一句“hi”就要花费2美分。与DeepSeek-R1相比,o1-pro的价格显得非常不亲民。DeepSeek还提供错峰优惠,进一步降低了使用成本。

为什么OpenAI要将o1-pro的价格定得如此之高?

OpenAI将o1-pro定价如此之高,可能的原因包括:

- 高昂的计算成本: 为了提供更好的响应,o1-pro需要消耗更多的计算资源,成本自然水涨船高。

- 目标用户定位: o1-pro可能面向对性能要求极高的特定用户群体,他们对价格不敏感,更看重模型的质量和功能。

使用o1-pro模型有哪些潜在风险?

高昂的价格也带来了一些潜在风险:

- 意外的费用: 如果系统出现恶性循环,可能会在短时间内产生巨额费用。

- 成本控制: 开发者需要密切监控o1-pro的使用情况,避免超出预算。

如何使用OpenAI o1-pro 模型?

由于 o1-pro 模型仅对特定开发者开放,你需要确保你的 OpenAI 账户属于 Tier 1-5 级别。以下是使用步骤:

- 检查你的 OpenAI 账户等级:

- 登录到你的 OpenAI 开发者平台。

- 查看你的账户信息,确认你的账户等级在 Tier 1 到 Tier 5 之间。

- 访问 OpenAI API 文档:

- 前往 OpenAI 官方文档,找到 o1-pro 模型的相关信息。

- 设置 API 请求:

- 在你的代码中,设置 API 请求以使用 o1-pro 模型。

- 确保你的请求包含必要的参数,例如模型名称、输入文本等。

- 处理 API 响应:

- 解析 API 响应,获取模型生成的文本或其他结构化数据。

- 根据你的应用需求,处理和展示这些数据。

示例代码 (Python):

python

import openai

openai.api_key = “YOUR_API_KEY” # 替换为你的 OpenAI API 密钥

def generate_text(prompt):

response = openai.Completion.create(

engine=”o1-pro”, # 确保模型名称正确

prompt=prompt,

max_tokens=150, # 根据需要调整

n=1, # 生成多少个回复

stop=None, # 可选:停止生成的词语

temperature=0.7, # 可选:调整生成文本的随机性

)

return response.choices[0].text.strip()

if name “main“:

user_prompt = “请用一句话总结 OpenAI o1-pro 模型。”

generated_text = generate_text(user_prompt)

print(generated_text)

注意事项:

- 替换

YOUR_API_KEY为你实际的 OpenAI API 密钥。 - 根据你的具体需求调整

max_tokens和temperature参数。 - 确保你的 OpenAI 账户有足够的余额来支付 o1-pro 模型的使用费用。

, , #o1-pro, , ,

我认为:OpenAI推出o1-pro,宛如富家翁炫耀其金缕玉衣,虽精美绝伦,然高价令人咋舌。DeepSeek之亲民,反衬出其曲高和寡。此举是OpenAI自信之体现,亦是市场细分之必然。然定价过高,终究有“孤芳自赏”之嫌,长此以往,恐失却大众之心。

© 版权声明

文章版权归作者所有,未经允许请勿转载。