什么是Still-Moving框架?如何实现T2V模型的定制化生成?

定制化在日常生活中已十分常见,但你是否听说过大模型的定制?近年来,文生图模型的定制化发展迅速,而文生视频模型的定制化仍然在探索阶段。不过,谷歌DeepMind团队的最新研究,提出了名为Still-Moving的创新型框架,能够实现T2V(Text-to-Video)模型的定制化生成。这一突破性成果表明,未来视频生成领域将不再依赖定制视频数据,极大推动了AI生成技术的发展。

为什么视频生成的定制化难以实现?

视频生成的定制化起步较慢的原因在于:缺乏定制化视频数据。相比于图像生成,视频的动态性和复杂性更高,数据获取成本也远超图像。通常,视频需要大量的连续帧来展现动态内容,而这些数据在定制化项目中难以收集和处理。

Still-Moving框架的出现正是为了解决这一难题。该框架引入了一个不需要定制视频数据的通用解决方案,能够通过少量的静态参考图像来生成高质量的视频。

Still-Moving框架的创新之处是什么?

Still-Moving能够将T2I模型(文本生成图像模型)的定制化成果,扩展到T2V模型(文本生成视频模型)。其核心创新在于:

- 静态参考图像的使用:仅需少量静态参考图像,便可调整任何T2I模型的权重,与T2V模型保持一致。

- 保留运动先验:通过保持T2V模型原本的运动先验,模型能够生成自然流畅的动态效果。

具体如何实现Still-Moving定制化?

Still-Moving定制化的实现依赖于两大核心步骤:

1. 运动适配器训练

通过引入运动适配器,该步骤控制模型生成视频的运动量。运动适配器在训练时,使用的是静态视频数据,即从参考图像中获取的静态帧。这一步骤使模型学会生成具有轻微运动的视频内容。

2. 空间适配器训练

此步骤通过注入定制化的T2I权重,结合定制化的图像与自然视频的数据进行训练。空间适配器使模型在保留运动先验的基础上,适应定制化的空间信息。这意味着,视频中的对象不仅会遵循参考图像的风格,还会呈现出动态变化。

Still-Moving如何在多种任务中展示其有效性?

DeepMind团队在多个任务上验证了Still-Moving框架的能力,包括个性化生成、风格化生成和条件生成。在所有评估场景中,Still-Moving都表现出色,成功结合了定制化T2I模型的空间先验与T2V模型的运动先验,生成出高质量、自然流畅的视频内容。

下面是几种具体应用案例:

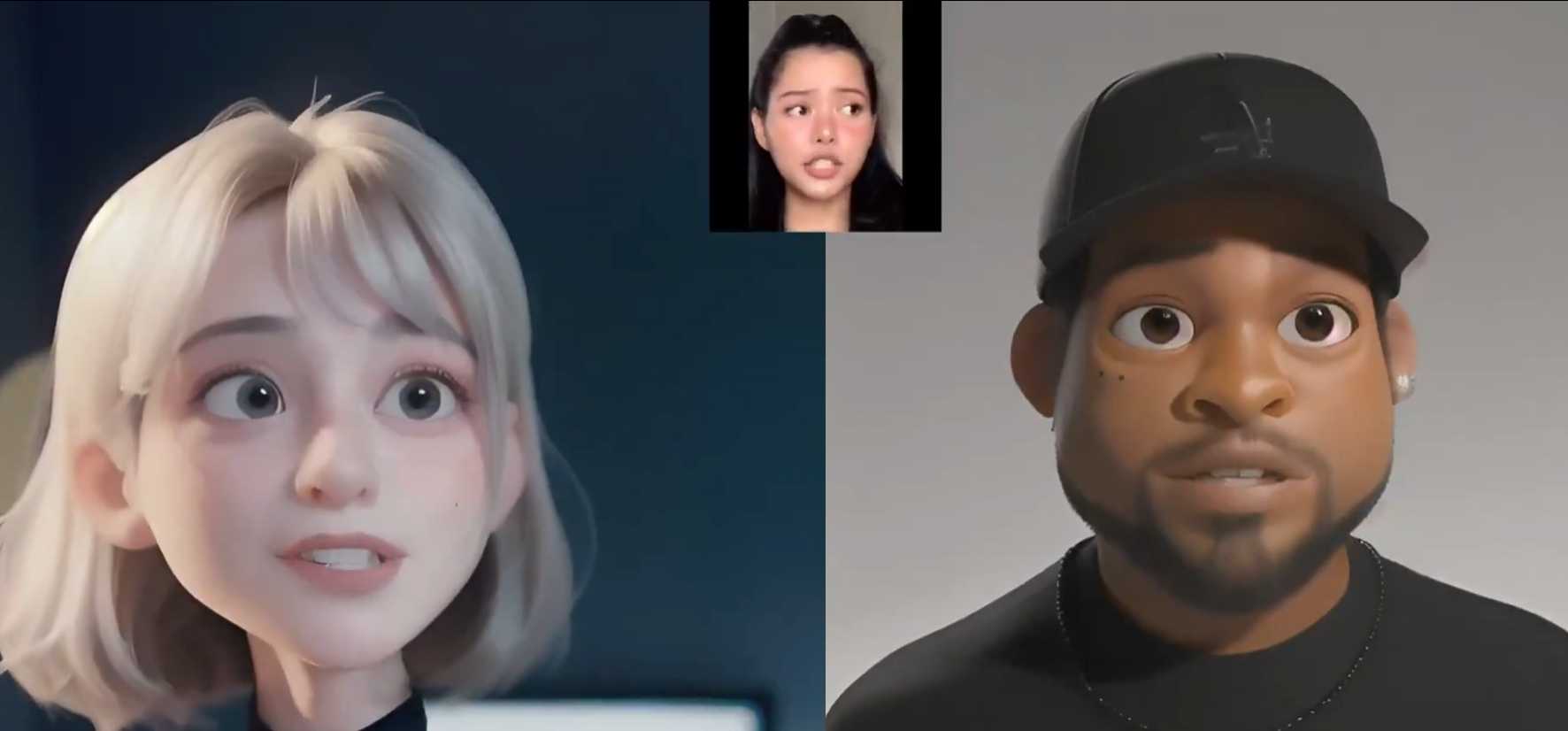

- 个性化生成:仅需输入个性化的静态图像,Still-Moving便可以生成独特的视频内容。

- 风格化生成:通过注入特定的风格信息,生成的视频具有一致的艺术风格,同时保留了自然的动态效果。

- 条件生成:依据特定条件(如动作指令或环境设定)生成符合要求的定制化视频。

Still-Moving的实际应用案例

在AnimateDiff T2V模型上应用Still-Moving框架后,研究团队将其与简单注入方法进行了对比。Still-Moving生成的视频内容展现了更高的自然性与一致性。特别是在多个参考图像的生成案例中,Still-Moving的效果明显优于传统方法。

通过以下几组对比可以更清晰地感受到该框架的优势:

- 参考图生成对比:Still-Moving生成的视频更加流畅,参考图像中的人物或物体在视频中的运动表现出更自然的过渡。

- 风格化视频生成:视频风格保持了参考图像的艺术风格,同时动态效果无缝连接。

结论:Still-Moving框架的意义与未来展望

Still-Moving扩展了T2I模型的定制化成果至视频生成领域,克服了定制化视频数据短缺的问题,为AI视频生成领域开辟了新的路径。DeepMind团队的这一创新,标志着高质量定制化视频生成的新时代即将到来。可以预见,随着技术的进一步发展,视频生成的个性化与多样化将更广泛应用于电影制作、广告创意、游戏设计等多个行业。

我认为:

定制化的未来不仅属于图像生成,也将属于视频生成。Still-Moving框架让我们看到了AI生成技术迈向动态世界的无限可能。通过结合运动先验与空间先验,我们不再依赖庞大的视频数据,而是通过少量静态图像实现创意的动态展现。这不仅提升了视频生成的效率,也使得个性化内容创作变得更加灵活与可行。未来,AI将真正成为我们想象力的延伸工具,而定制化视频生成正是通往这一未来的重要一环。

keywords: #AI

© 版权声明

文章版权归作者所有,未经允许请勿转载。