本地部署llama3,不用联网、完全免费、可以商用、隐私数据安全零隐患!最新meta公司开源的llama3大模型可以吊打一众友商,普通的电脑就可以轻松部署!llama3部署教程来了!这里我们需要下载部署三套程序,分别是1、ollama,主要用于部署开源模型。2、docker,是一个容器,可以本地部署lobeHub程序。3、lobeHub,可以使用开源大模型的Web UI界面,下面我们开始具体操作。

操作步骤

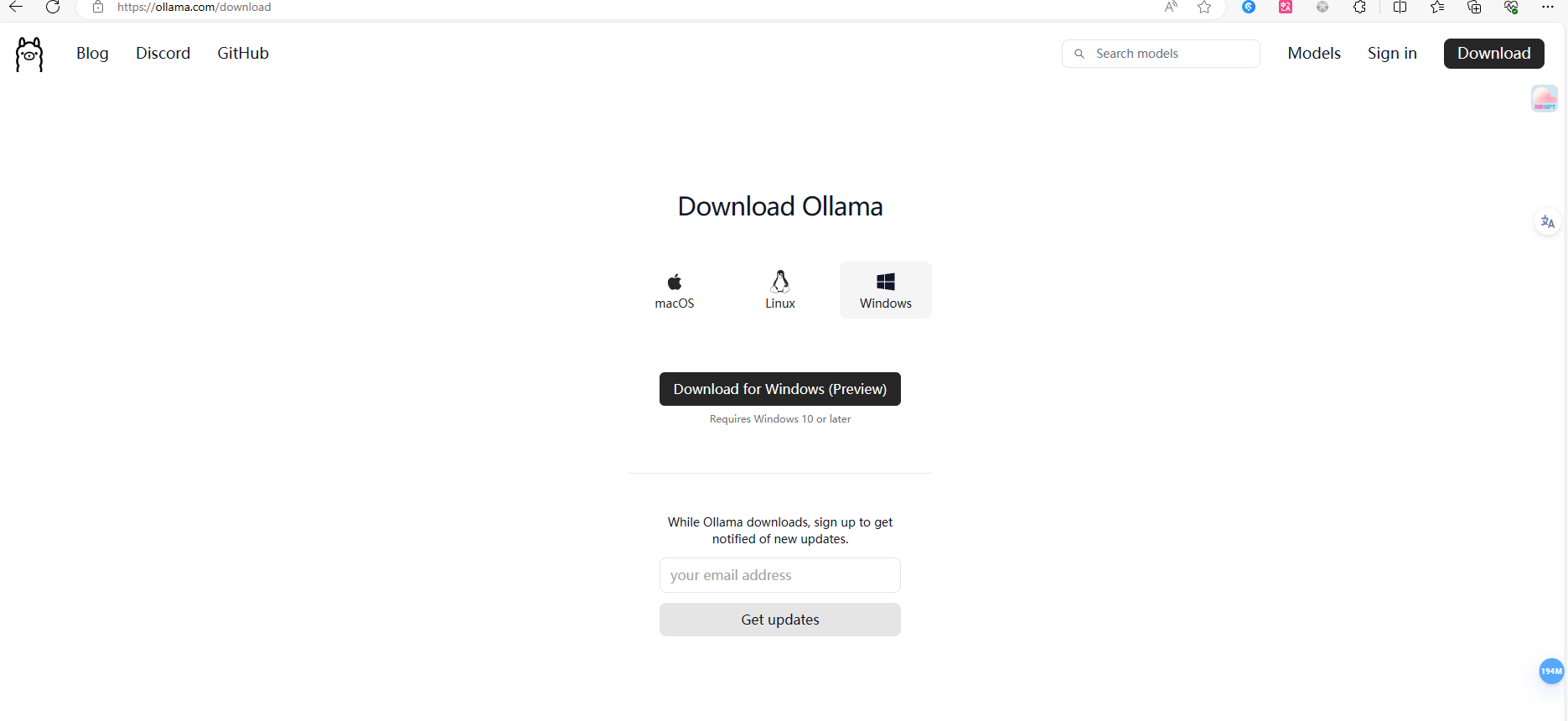

操作步骤:“简单几步来部署你的AI模型:1、 下载ollama,访问ollama.com并下载适合你系统的版本;

2、下载启动模型,右上角点击models,如果 显存小可直接选择llama3(5G)模型 。我的显存是22G,本次以8b-instruct-q8_0(8.5G)这个模型为例,运行这段代码:ollama run llama3:8b-instruct-q8_0,就会下载该模型。下载完成后就可以直接使用llama3来进行对话了。

如果你想要一个好看web ui。那就再继续往下操作两步,

安装时,全部选择默认,安装完成后会提示重启,重启后可能没有左侧菜单,这时候我们使用梯子来登陆,就会出现这个页面,说明已经成功了。

我们可以看一下右下角已经有两个图标,然后进行下一步,安装lobe-chat

第二步,安装lobe-chat,运行这段代码,

docker run -d -p 3210:3210 --name lobe-chat lobehub/lobe-chat

会下载lobehub这个开源程序,下载完成之后,我们回到docker会看到这里已经有了这个项目,然后点击这里就可以打开这个页面。

在这里我们可以设置好本地模型,也可以设置api,

这样就可以在这里任何跑本地大模型,也可以选择api的其它模型!

如果想加在线模型的API可以到这里购买,https://faka.zmgpt.cc然后填入到这里面>

lobeHUB这套程序还是非常不错的,他这里大量的提示词模板,我们可以随意使用! 本教程介绍了如何在本地部署llama3大模型,无需联网,免费商用且安全。通过下载ollama、docker和lobeHub等程序,可以轻松完成部署,并使用web UI界面进行模型操作。

本教程介绍了如何在本地部署llama3大模型,无需联网,免费商用且安全。通过下载ollama、docker和lobeHub等程序,可以轻松完成部署,并使用web UI界面进行模型操作。

© 版权声明

文章版权归作者所有,未经允许请勿转载。